Guida rapida: URL ottimizzati e strutturati in ottica SEO

Molte persone, quando visitano una pagina online, non prestano molta attenzione al suo indirizzo URL, equivalente in forma di lettere e numeri dell’IP numerico che definisce la posizione di una risorsa in rete. Lo Unique Resource Locator è invece uno dei primi elementi che Google Bot valuta nella scansione di una pagina.

In un articolo di qualche giorno fa avevo dato alcuni consigli su come scrivere URL ottimizzati, concentrandomi su sintassi ed efficacia in termini di posizionamento sui motori. Oggi voglio invece approfondire la relazione tra URL e pratica SEO con qualche mossa un po’ più sottile per garantire al vostro sito un sistema con indirizzi ben strutturati e appetibili per i motori.

Ecco i miei 5 suggerimenti su come rendere i nostri URL più digeribili:

1. Dare valore agli URL raggruppando i domini ridondanti

Uno delle ragioni più comuni della perdita di punteggio nei ranking è la presenza di domini non consolidati nel nostro sito, con una conseguente diluizione del valore della pagina e dei link in ingresso. Prendiamo i seguenti URL:

– sito-esempio.com

– http://sito-esempio.com

– www.sito-esempio.com/index.html

– www.sito-esempio.com/

Tutti rimandano allo stessa dominio di base (www.sito-esempio.com), ma se il motore li visualizza come pagine differenti, il guaio è fatto: il valore della pagina (e di tutte le pagine sottostanti) verrà suddiviso tra le diverse versioni dell’URL, facendo calare il ranking potenziale del sito.

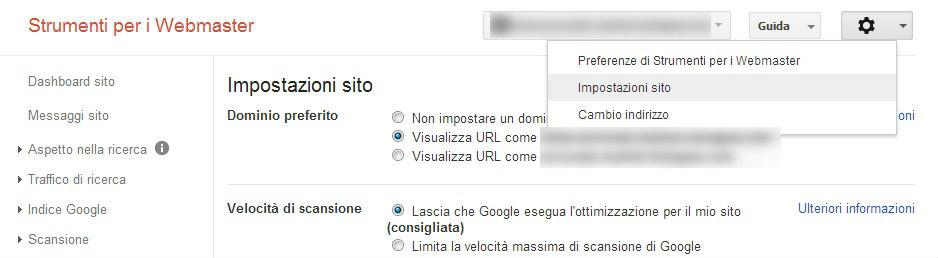

La soluzione applicata dalla maggior parte degli addetti ai lavori di ogni agenzia SEO è il buon, vecchio redirect 301, comando lato server (disponibile anche in versione plugin per CMS come WordPress e Joomla) che permette di far puntare gli URL ridondanti a quello principale. Nel caso non sia possibile eseguire un redirect 301, una possibile alternativa è configurare il dominio preferito in Google Webmaster Tools ( Ingranaggio > Impostazioni sito > Dominio preferito); purtroppo questa soluzione funziona solo per la radice di un dominio e non è valida per URL come quelli generati dai blog come wordpress e simili.

2. Evitare gli URL dinamici e usare quelli statici

Come già anticipato nel precedente articolo su questo tema, un buon URL ottimizzato è scritto in maniera leggibile e chiara. Per questo è consigliabile riscrivere (per le pagine che ci interessano) gli indirizzi generati in automatico da qualche CMS o nel caso di URL con variabili (spesso utilizzate nelle pagine articoli di un e-commerce). Un esempio visivo può aiutare a chiudere la questione sul nascere:

www.sito-esempio.com/argomento-pagina-sito

è decisamente meglio di

www.sito-esempio.com/?q=87_N2364?ID=arg_421

Anche se a livello di codice non ci sono errori (la pagina viene letta correttamente dal motore), gli URL dinamici sono semplicemente scomodi da leggere per l’utente e inutili da un punto di vista di search engine optimization; ricordiamo infatti che un URL può contenere keyword e acquisire valore. Inoltre, su indicazione stessa di Google, è meglio evitare gli underscore a favore dei trattini negli URL, banalmente perché il motore non li legge. Un URL come “sono_un_uomo_non_un_nonno” verrà infatti letto come “sonounuomononunnonno”, un’unica parola senza senso. E addio all’ottimizzazione keyword.

3. Creare una sitemap XML

Qui è il caso di fare subito chiarezza. La sitemap XML non è la sitemap del sito, grafica o HTML che sia. Quella XML è utile ai motori di ricerca, le altre sono dedicate all’utente.

Il file XML, che deve essere situato all’interno della directory principale del sito, consiste in un semplice elenco degli URL del sito stesso. In ottica SEO, una sitemap XML è utile perché contiene gli URL che si vogliono indicizzare e l’indicazione di quali siano gli URL canonical a cui i motori devono fare riferimento. Nel prossimo punto capiremo perché i canonical siano così importanti.

4. Utilizzare il tag rel=”canonical”

Abbiamo visto quanto sia importante dare indicazioni precise ai motori su quali pagine indicizzare, facendo puntare pagine con URL ridondanti verso uno principale utilizzando un redirect 301. Esistono poi alcuni casi in cui è consigliabile utilizzare un particolare tag HTML all’interno del codice di una pagina per fare in modo che questa rimandi a quella principale. Facciamo un esempio:

- Questo URL manda a una pagina prodotto:

http://www.sito-esempio.com/categoria/prodotto-dettaglio?id=817452&prezzo&lang=it

- Questo URL rimanda alla stessa pagina, con parametri diversi:

http://www.sito-esempio.com/categoria/prodotto-dettaglio?id=817452&prezzo&lang=it%tax=22%selezionato

- Aggiungendo nel codice HTML di entrambe le pagine il tag seguente:

si darà indicazione al motore che la pagina principale da considerare è quella contenuta nel canonical, invece di quelle con URL dinamici complessi e non SEO-Friendly.

Impostare correttamente e senza confusione i tag canonical (così come i redirect) è un’indicazione che arriva direttamente dagli sviluppatori stessi di BigG che avuto modo di sentenziare: “Se non siamo in grado di rilevare tutti i duplicati di una particolare pagina, non saremo in grado di consolidare le sue proprietà. Questo può portare a una diluizione della forza dei segnali di ranking, suddividendoli su più URL”. Vi ricorda niente? Ne abbiamo parlato a inizio articolo.

5. Compilare correttamente il file robots.txt

Ultimo punto di questo piccolo vademecum sull’ottimizzazione degli URL, l’utilizzo del file robots.txt nel nostro sito. Questo piccolo file di testo rappresenta uno dei riferimenti principali che Google utilizza per scansionare un sito.

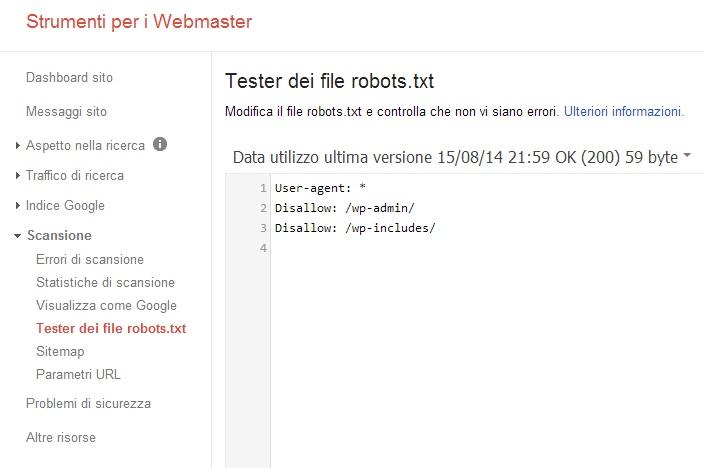

Come detto in precedenza, meglio non indicizzare pagine inutili o di sistema. Per farlo si possono inserire gli URL indesiderati nel file robots.txt, avendo cura di includerli sotto il comando Disallow: come in figura. Il comando User-agent: indica invece a quali motori fornire indicazioni, con l’asterisco a indicare istruzioni valide per tutti i motori.

Per un test veloce e per sperimentare con la sintassi del file robots.txt può essere utile servirsi dello strumento apposito fornito da Webmaster Tools, come sopra.

Conclusioni

Il consiglio finale per avere URL ottimizzati che ci aiutino a salire nei posizionamenti è quello di controllare con attenzione la loro struttura, con un occhio particolare a eventuali errori o dimenticanze che possono essere nascosti nel codice HTML delle pagine, nel file robots.txt, come indirizzi duplicati o keyword diluite. Ripulire un sito in questo senso, inoltre, è un ottimo esercizio SEO che unisce scrittura contenuti, gestione del codice e furbizie con le keyword. Buon divertimento!